Летом 2023 года OpenAI создала команду Superalignment, целью которой было управление и контроль будущих систем ИИ, настолько мощных, что они могли бы угрожать существованию человечества. Менее чем через год эта команда прекратила своё существование.

OpenAI сообщила Bloomberg, что компания "глубже интегрирует группу в свои исследовательские усилия для достижения целей безопасности". Однако серия твитов от Яна Лейке, одного из лидеров команды, который недавно ушёл из OpenAI, раскрыла внутренние напряжения между командой безопасности и остальной компанией.

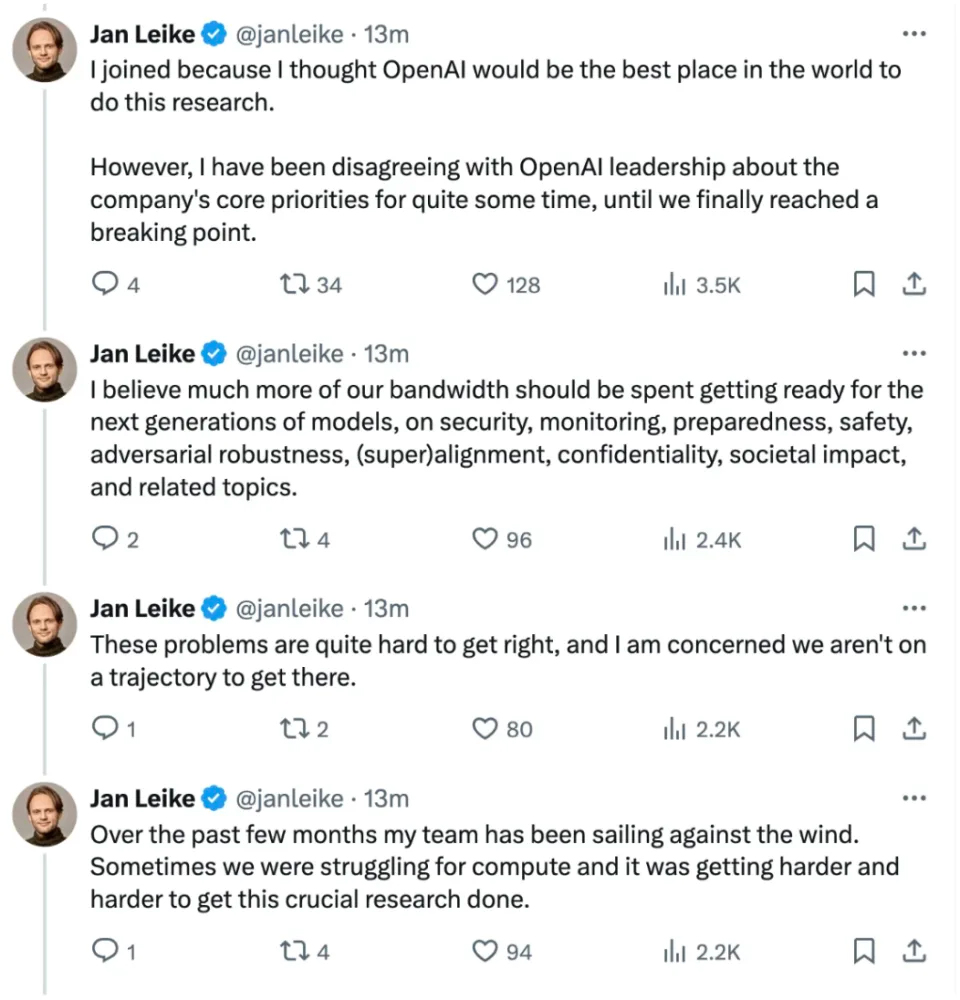

В заявлении, опубликованном в X в пятницу, Лейке сказал, что группа Superalignment боролась за ресурсы для проведения исследований.

Создание машин, умнее человека, по своей сути опасное занятие. OpenAI несёт огромную ответственность за всё человечество. Но за последние годы культура и процессы безопасности отступили на второй план перед яркими продуктами.

Уход Лейке ранее на этой неделе произошёл через несколько часов после того, как главный научный сотрудник OpenAI, Илья Суцкевер, объявил о своём уходе. Суцкевер был не только одним из лидеров команды Superalignment, но и одним из сооснователей OpenAI.

Его уход произошёл через шесть месяцев после того, как он принял участие в решении об увольнении генерального директора Сэма Альтмана из-за опасений, что Альтман не был "постоянно откровенен" с советом директоров. Кратковременное увольнение Альтмана вызвало внутренний бунт в компании, и почти 800 сотрудников подписали письмо с угрозой уволиться, если Альтман не будет восстановлен на посту генерального директора. Через пять дней Альтман вернулся на пост генерального директора.

Когда было объявлено о создании команды Superalignment, OpenAI заявила, что выделит 20% своей вычислительной мощности в течение следующих четырёх лет на решение проблемы контроля мощных систем ИИ будущего. "Достижение этого — критически важно для выполнения нашей миссии," писала компания в то время. А в X Лейке написал, что команда Superalignment "боролась за вычислительные ресурсы, и это становилось всё труднее и труднее" для проведения важных исследований по безопасности ИИ. "В последние месяцы моя команда плыла против ветра," написал он, добавив, что достиг "предела" в отношениях с руководством OpenAI из-за разногласий по поводу основных приоритетов компании.

В последние месяцы из команды Superalignment ушли и другие сотрудники. В апреле OpenAI уволила двух исследователей, Леопольда Ашенбреннера и Павла Измайлова, за якобы утечку информации.

OpenAI сообщила Bloomberg, что её будущие усилия по обеспечению безопасности будут возглавлять Джон Шульман, другой сооснователь, чьи исследования сосредоточены на крупных языковых моделях. Якуб Пачоцкий, директор, который возглавлял разработку GPT-4 — одной из флагманских языковых моделей OpenAI, заменит Суцкевера на посту главного научного сотрудника.

Superalignment была не единственной командой в OpenAI, сосредоточенной на безопасности ИИ. В октябре компания создала новую команду "готовности" для предотвращения потенциальных "катастрофических рисков" от систем ИИ, включая проблемы кибербезопасности, а также химические, ядерные и биологические угрозы.